Il y a quelques semaines, vous étiez invité à répondre au sondage inédit Alliancy sur votre vision de l’éthique en intelligence artificielle (IA). Nous remercions les 113 personnes qui ont pris le temps de répondre. Nathalie Nevejans, titulaire de la Chaire IA Responsable à l’Université d’Artois et Maître de conférences en droit vous propose d’en décrypter ses résultats.

Nathalie NEVEJANS, Titulaire de la Chaire IA Responsable (Droit et éthique en IA) – Maître de conférences HDR en droit (Université d’Artois) – chroniqueuse experte Alliancy

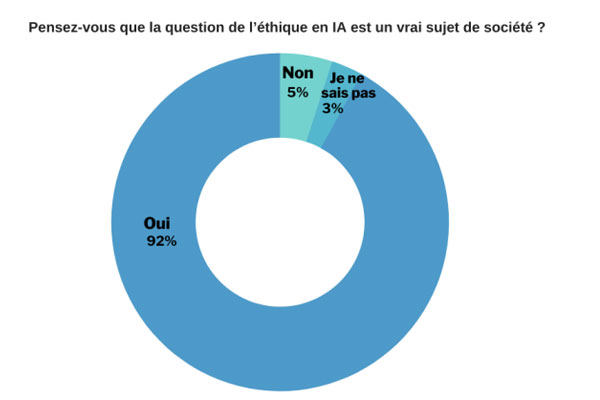

L’IA est aujourd’hui partout dans notre vie quotidienne, sur nos réseaux sociaux et autres moteurs de recherche, dans la rue, dans nos campagnes et sur notre lieu de travail. Source d’avancées spectaculaires, l’IA a aussi un revers à sa médaille car elle présente parfois des risques en termes de droits humains. Ce n’est pas neutre d’être constamment surveillé, conseillé, informé, classifié, annoté, guidé ou assisté par un système d’IA. Deux scandales ont marqué les esprits. En 2016, avec les données personnelles de 87 millions d’utilisateurs Facebook, la société Cambridge Analytica avait utilisé l’IA pour manipuler bon nombre d’électeurs sur les réseaux sociaux lors de l’élection américaine. Récemment, Timnit Gebru, responsable du département de l’éthique de l’IA chez Google, semble avoir été licenciée après avoir critiqué son employeur dans un article sur les biais discriminatoires en IA. L’éthique de l’IA a pour but de limiter ces impacts négatifs pour mettre une IA au service du bien de tous. Les répondants ont bien pris la mesure des enjeux éthiques de l’IA puisqu’ils répondent par l’affirmative à 92 % à la question « Pensez-vous que la question de l’éthique en IA est un vrai sujet de société ? ». Si 5 % d’entre eux estiment que ce n’est pas un sujet, seuls 3 % ignorent comment répondre.

Une législation plus contraignante

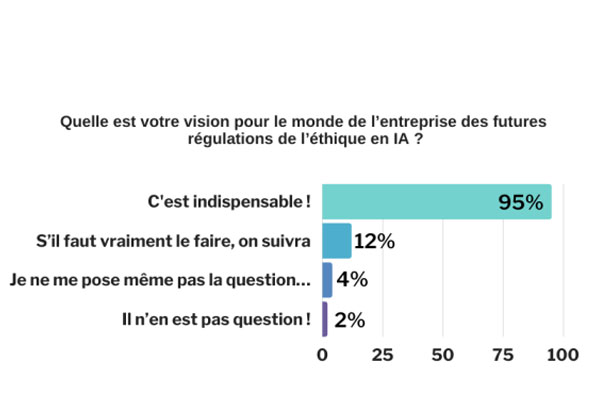

Après la résolution du Parlement européen du 20 octobre 2020 fixant un cadre pour les aspects éthiques de l’intelligence artificielle, l’Union européenne a entrepris d’élaborer une législation plus contraignante. L’éthique de IA devient donc un sujet incontournable pour les entreprises. Les répondants semblent d’ailleurs en avoir conscience puisque, à la question « Quelle est votre vision pour le monde de l’entreprise des futures régulations de l’éthique en IA ? », 84 % des répondants estiment que c’est indispensable. 13 % sont moins d’accord (11 % suivront s’il faut le faire, et seulement 2 % s’y opposent). Seuls 3 % ne se posent pas la question.

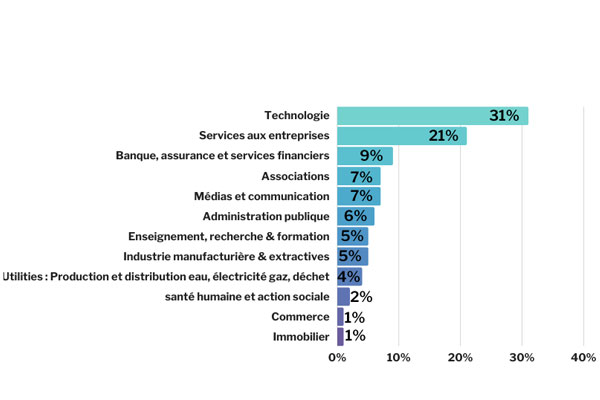

Il est intéressant de mettre ces chiffres en relation avec la taille de l’entreprise des répondants. En effet, 55 % d’entre eux travaillent dans une entreprise de taille moyenne ou importante (> 50 salariés). Il est étonnant de constater que l’éthique de l’IA ne les interroge pas beaucoup plus que les entreprises plus modestes. Est-ce parce que leur modèle de gouvernance n’est plus adapté à ces nouveaux défis ? Si on corrèle ce résultat avec le secteur d’activité des répondants, seuls deux secteurs sur les douze répertoriés cumulent 52 % (31 % « Technologie », 21 % « Services aux entreprises »). C’est bon signe qu’ils soient très présents, puisque l’IA y est déployée largement. On peut cependant regretter que ceux dans lesquels l’IA a déjà une vraie place soient faiblement représentés (9 % « Banque, assurance et services financiers », 6 % « Administration publique », 5 % « Industrie manufacturière & extractive », et 1 % « Commerce »).

Nécessaire auto-évaluation

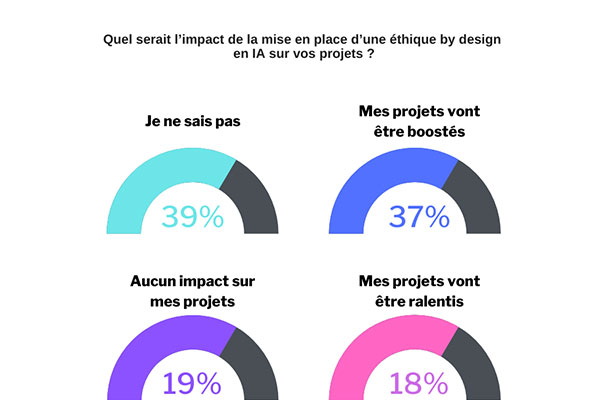

Depuis ses « Lignes directrices en matière d’éthique pour une IA digne de confiance » d’avril 2019, et son « Livre blanc Intelligence artificielle. Une approche européenne axée sur l’excellence et la confiance » de février 2020, l’Union européenne incite les entreprises à auto-évaluer d’un point de vue éthique leurs outils, produits et systèmes d’IA de façon à pouvoir protéger les personnes (salariés, fournisseurs, clients utilisateurs, …). La règlementation en cours d’adoption pourrait même les contraindre à réaliser cette auto-évaluation. Il s’agira pour elles de vérifier que leur IA respecte les principes éthiques et les droits humains, et de s’assurer qu’elle est robuste sur le plan technique. Les entreprises ne sont pas effrayées par ces nouvelles contraintes puisque, à la question « Quel serait l’impact de la mise en place d’une éthique by design en IA sur vos projets ? », les répondants sont globalement positifs ou sans a priori trop négatifs. Ainsi, 84 % d’entre eux ne sont pas d’emblée hostiles à l’évolution de la règlementation (33 % sont enthousiastes, 17 % pensent qu’il n’y aura pas d’impact, 34 % ne savent pas). 84 %, c’est exactement le nombre de répondants qui estimaient déjà indispensables l’adoption d’une régulation. Cela montre une grande cohérence de leur réflexion. Les 16 % qui restent sont en adéquation avec les 13 % des moins convaincus de la pertinence d’une régulation, auxquels s’ajoutent ceux qui ne savaient pas.

Tech In Sport

Tech In Sport Green Tech Leaders

Green Tech Leaders International

International Nominations

Nominations Politique publique

Politique publique