Pourquoi le terme “fake news” envahit depuis plusieurs années notre discours alors que la désinformation ne date pas d’hier ? Tout simplement car l’avènement d’Internet amplifie le phénomène et permet à n’importe qui d’atteindre une grande audience en quelques clics. Sans filtre, les fausses informations circulent massivement sur la Toile et peuvent nuire autant au débat public qu’à la réputation des personnes et des organisations. Cet article vous propose de comprendre pourquoi la désinformation prospère davantage aujourd’hui et comment elle se propage afin de mieux s’en protéger.

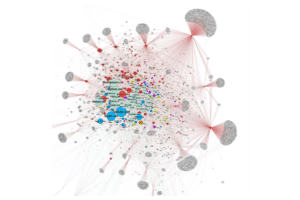

Le professeur à l’université de Columbia Jonathan Albright a utilisé des outils de data visualisation pour montrer comment se diffusent les fakes news. Il a analysé plus de 80 000 hyperliens propagés pendant les élections américaines de 2016 par 117 sites internet complotistes.

Mardi 22 novembre 2016 à 16 heures 05, les agences de presse françaises reçoivent un faux communiqué aux conséquences sans précédent pour le géant du BTP Vinci. Il y est annoncé que le directeur financier a été licencié pour de graves erreurs comptables correspondant à plus de 3 milliards d’euros sur la période 2015-2016. Reprise par certains médias dans la foulée, l’information affole la bourse parisienne et Vinci, malgré son démenti, voit son action décrocher de près de 20%.

Comment une simple rumeur, présentée comme officielle, a-t-elle pu percer le filtre médiatique et tromper certains journalistes ? Comment en est-on arrivé au point qu’une fausse information puisse faire dégringoler aussi facilement les cours boursiers d’un grand groupe ? Dans le cas de Vinci, les personnes à l’origine de cette fausse rumeur ont simplement utilisé le modèle officiel des communiqués de presse diffusés par la firme. Mais dans certains cas, une simple rumeur partagée sur les réseaux peut prendre des proportions ahurissantes, sans l’aide des médias.

En juillet 2015, par exemple, Microsoft, a dû faire face à une rumeur concernant sa console phare “Xbox”, insinuant qu’elle aurait tranché la gorge d’un jeune homme à cause d’un défaut dans son système d’éjection de CD. Diffusée à l’origine par le site NewsWatch33.com, la fausse information a été partagée des dizaines de milliers de fois et Microsoft s’est empressé de contredire les faits.

Même formule pour Starbucks deux ans plus tard, qui a été forcé de répondre aux accusations de racisme de la part de l’opinion publique, à cause d’une rumeur diffusée par le forum 4Chan qui prétendait que la firme allait donner gratuitement des cappuccinos à tous les immigrants entrés clandestinement aux Etats-Unis. La fausse information a essaimé les réseaux à travers des hashtags « #DreamerDay », « #Borderfreecoffee », a donné lieu à des images truquées et a généré des milliers de tweets indignés.

Pour se protéger de ce fléau, les organisations et les citoyens doivent mieux appréhender comment ces rumeurs d’un nouveau genre circulent sur le web. Force est de constater que l’avènement d’Internet et des nouvelles technologies de communication a amplifié leur diffusion. Les mécaniques de la désinformation ne datent pas d’hier, mais elles bénéficient aujourd’hui d’un terreau fertile pour gagner en impact. Les journalistes, auparavant considérés comme “gardiens de l’information”, ont perdu le monopole de la production de contenu. Et les entreprises, elles, peinent à garder la maîtrise de leur propre réputation.

Que la diffusion de ces fake news soit intentionnelle ou non, il n’en demeure pas moins qu’elle se généralise. Nous pourrions également nous perdre dans les méandres des messages complotistes autour de Linky ou de la 5G pour comprendre pourquoi certaines industries en viennent à se justifier publiquement sur des théories farfelues. Le fait est que l’adhésion du public est souvent indispensable à la pérennité de son business et le risque de voir sa réputation entachée en ligne est d’autant plus fort, étant donné l’anonymat et l’autonomie dont bénéficient tous les internautes. Cette situation reste donc difficile à gérer pour les entreprises quand on sait à quel point le temps consacré à rétablir la vérité est bien plus long que celui utilisé pour propager une fausse nouvelle.

Internet, ou la fin du gatekeeping

L’inquiétude face aux effets des fausses informations est apparue en particulier depuis les élections présidentielles américaines de 2016. C’est à ce moment que l’on prend conscience de la nécessité d’agir pour restaurer la vitalité du débat public. Robert Mueller, procureur spécial chargé d’enquêter sur cette affaire, avait dénoncé l’ingérence du Kremlin visant à faire basculer l’élection américaine au profit de Donald Trump. Car oui, la désinformation n’est pas seulement le fruit d’un emballement d’une foule en ligne.

Ici, le modus operandi des “trolls” russes est grandement facilité par le manque de contrôle des géants du numérique sur leurs propres plateformes. Ces failles sont exploitées par ces cyber-armées qui utilisent des faux comptes automatisés par des « social bots » (programme permettant d’automatiser des tâches en ligne tels que la publication de contenu) pour diffuser des messages désinformants en masse. L’objectif est de susciter des réactions sur des sujets clivants et ils peuvent compter sur le système de sponsoring publicitaire qui permet d’amplifier la viralité des faux contenus. L’astroturfing fait aussi irruption sur le web comme un grain disruptif dans une mare d’intox. Cette technique réussit à influencer l’opinion publique en cultivant l’illusion d’un phénomène de masse en ligne, une fausse mobilisation citoyenne montée de toutes pièces.

Ce chaos gagne du terrain à mesure que la figure traditionnelle du gatekeeper s’amenuise. Concrètement, le gatekeeping désigne les intermédiaires qui sont chargés de gérer et filtrer les informations qui circulent sur l’espace public. Traditionnellement attribué au journalisme ou bien au pouvoir politique, ce rôle permet de rendre visible une information auprès du public et des institutions. Mais à l’ère de la post-vérité, l’absence de confiance consensuelle en une figure de gatekeeper brouille les pistes et rend les professionnels des médias inaptes à vérifier l’information qui circule. Tout simplement car sur le web, n’importe qui peut s’exprimer librement et peut aspirer à être entendu.

La prise de parole est bien plus libre et augmente massivement le nombre de flux informationnels. Ce n’est plus les médias traditionnels qui décident quel contenu sera rendu visible mais bien les algorithmes. C’est d’ailleurs ce que Dominique Cardon qualifie de passage d’un « contrôle éditorial a priori à un contrôle a posteriori ». Sur le web, toute prise de parole est rendue publique par défaut et les algorithmes ou moteurs de recherches développés par les géants du net opèrent une nouvelle forme de filtrage.

La désinformation : Quésaco ? D’où vient-elle ?

Il est temps de comprendre ce qu’est la désinformation et d’où vient-elle. Spoiler : nous verrons qu’elle ne date pas d’hier, et encore moins d’aujourd’hui. La désinformation est bien plus qu’un simple mensonge qui circule sur la Toile. C’est ce que François-Bernard Huyghe, directeur de recherche à l’IRIS (Institut de Relations Internationales et Stratégiques), souhaite clarifier dans son ouvrage « Désinformation : les armes du faux ». Selon lui, il faut avant tout éviter de confondre la désinformation avec le simple mensonge, le stratagème, la manipulation, l’intoxication, l’aveuglement idéologique… la désinformation, elle, comprend 3 critères cumulatifs :

– une « intention stratégique » qui consiste à fabriquer de faux contenus tels que des images retouchées.

– une « intention médiatisée » avec un contenu relayé par des médias ou des communautés virtuelles qui amplifient le message.

– un « processus [qui] serve aux intérêts de son initiateur au détriment de la cible », autrement dit un emballement chez les internautes qui sont attirés par l’extraordinaire, l’occulte voire la conspiration.

La désinformation a toujours existé mais le mot n’est apparu qu’en 1953 dans le dictionnaire soviétique et en 1980 à l’Académie Française. On comprend alors l’avance considérable que la Russie avait en la matière et cet écart s’est creusé tout au long de la Guerre Froide. Dans un article de 2009, le chercheur Thomas Boghardt précise que « La pratique du renseignement différait considérablement de part et d’autre du rideau de fer. Tandis que les services de renseignement occidentaux étaient le plus souvent chargés de rassembler des informations, leurs homologues soviétiques mettaient davantage l’accent sur des opérations de tromperie visant à l’influencer l’opinion ». En 1983, alors que l’épidémie du SIDA commence à apparaître, le KGB lançait l’opération « Infektion »: une large campagne de désinformation destinée à faire croire que l’épidémie a été créée dans un laboratoire secret d’armes biologiques dans le Maryland.

Cette rumeur était bien entendue montée de toutes pièces mais une chose demeurait vraie : il existait bien un institut à Fort Detrick dans le Maryland qui était spécialisé dans la recherche médicale sur les maladies infectieuses. Cette simple confusion avec la réalité permettait de semer le désordre et le doute dans l’opinion. Le KGB avait bien compris que la désinformation pouvait servir à des fins géopolitiques et il s’est emparé de plusieurs cas comme l’assassinat du président Kennedy.

La chute de l’URSS n’a pas pour autant annoncé la fin de la désinformation qui s’est petit à petit privatisée à mesure que les technologies de l’information et de la communication ont fait irruption. Qui plus est, les Etats ne sont pas les seuls à avoir embrasser la désinformation pour servir ses intérêts.

La fin du monopole de la production de l’information

Cette fabrique de faux contenu s’insère dans un écosystème informationnel en pleine mutation. La transition numérique a amplifié le phénomène et permis des pratiques malveillantes d’un nouveau genre ; à l’image par exemple de l’astroturfing qui vise à faire croire en un mouvement citoyen spontané pour une cause par l’intermédiaire de faux comptes.

Alors que l’argument d’autorité est traditionnellement réservé aux scientifiques, dont la parole est relayée par les médias, il apparaît sur le web de moins en moins comme légitime. En effet, à l’ère numérique, tous les internautes sont égaux dans la manière de prendre la parole. On parle de l’avènement d’un système collaboratif et participatif de production de l’information. Par exemple, sur Wikipedia, lorsqu’il existe un désaccord sur une information traitée, les rédacteurs ont la possibilité de débattre sur une plateforme (onglet « discussion ») afin de trouver une entente et délivrer une opinion médiane. Ces rédacteurs ont par ailleurs pour interdiction de mentionner leur statut sous peine de bannissement. Il faut convaincre sans autorité.

Cette forme d’autorité est reconfigurée selon un principe de notoriété. Est amenée à être visible sur l’espace public toute personne qui bénéficie d’un large soutien d’internautes, de popularité. Les États ne sont plus les seuls acteurs de production d’information et sont en concurrence avec des internautes autonomes dans leur présentation des faits. Les médias traditionnels ont aussi dans le même temps perdu drastiquement le capital de confiance de la part du public, qui se réfugie sur les réseaux sociaux pour s’informer. Rien n’est plus facile de produire du contenu et de le diffuser à moindre coût. On assiste à une banalisation des techniques de fabrication, distribution (grâce au référencement et en maximisant l’optimisation algorithmique) et la diffusion massive de l’information (par les réseaux de communautés en ligne qui permettent la viralité du contenu ou bien par des moyens d’amplification liés à l’achat de « social bots » ou faux followers).

Le jeu Bad News vous met dans la peau d’un fabricant de fake news pour montrer quels sont les moyens possibles pour rendre un contenu sensationnel et donc viral.

Sur le web, à chaque sujet clivant il est possible de trouver des documents falsifiés, montages, fausses allégations et tout autre contenu fallacieux destiné à susciter la réaction ou manipuler. Et il est presque impossible de distinguer la désinformation de la simple rumeur. Il serait en théorie facile d’éviter les pièges en maîtrisant les outils de base pour vérifier la source de contenus. Mais à l’ère de l’infobésité et à cause de la surcharge informationnelle, les internautes n’appliquent pas assez les bonnes méthodes. La pénétration de la désinformation en ligne s’avère sans limite et s’inscrit dans une logique bien plus psychologique que mécanique.

L’attrait au sensationnalisme : un moteur pour les fake news

Pour comprendre pourquoi le poids des biais humains dans la prolifération des fake news semble plus important que celui des biais technologiques, attardons-nous sur une étude parue dans la revue Science le 9 mars 2018. Trois chercheurs du Massachusetts Institute of Technology ont apporté des preuves scientifiques sur le mécanisme de diffusion des fausses nouvelles sur les réseaux sociaux, preuves jusqu’à présent manquantes pour expliquer ce phénomène.

D’après eux, les fausses nouvelles sont diffusées « significativement plus loin, plus vite, plus profondément et plus largement que la vérité dans toutes les catégories d’information ». Ces fausses informations, surtout à caractère politique, bénéficient d’une diffusion virale en « cascades ». Elles ont 70 % de chances supplémentaires d’être retweetées que les vraies informations et la vérité a besoin de six fois plus de temps que la fausseté pour atteindre une cible de 1500 personnes.

À l’heure de l’automatisation accrue des moyens de diffusion de l’information, on aurait tendance à accuser les robots d’amplifier ce phénomène de désinformation. Mais les chercheurs ont intégré l’effet de ces « social bots » dans leurs calculs : cela ne change pas les résultats. Ce sont bien des humains qui sont à l’origine de ce chaos informationnel et tout simplement car « La nouveauté attire l’attention, contribue à une prise de décision productive et encourage le partage de l’information parce que la nouveauté met à jour notre compréhension du monde” précisent les auteurs. Le partage d’une fausse nouvelle est selon eux motivé par un attrait à la nouveauté, l’originalité d’une information qui suscite la surprise voire le dégoût. Les messages sensationnalistes sont donc ceux qui sont le plus impactant.

L’effet de groupe est aussi en jeu : un complotiste sur le web par exemple ne sera plus jamais isolé. Il peut compter sur des milliers d’internautes qui vont conforter son opinion, preuves à l’appui. Bernard Huygues distingue à travers ce phénomène deux tendances : d’une part un scepticisme de masse qui peut mener au complotisme et d’autre part, l’action des gouvernements et élites dominantes pour rétablir un contrôle du vrai en qualifiant toute critique du système comme une œuvre de désinformation. Réservée aux experts, journalistes et politiques, la « parole autorisée » se retrouve confrontée à une défiance alimentée par des thèses alternatives.

Quand targeting et bulles de filtres font bon ménage

L’adhésion aux faits alternatifs n’est pas seulement le résultat d’une simple manipulation ou mésinformation. C’est aussi une volonté de signifier son appartenance à une vision spécifique du monde. Et lorsque des communautés virtuelles se forment et s’isolent du discours des médias traditionnels, il est aisé pour elles de déterminer ses propres standards de vérité. C’est ce que Katharine Viner a démontré en utilisant pour la première fois le terme « post-vérité ». En 2016, la rédactrice en chef du Guardian s’était demandée pourquoi ses réseaux sociaux ne faisaient remonter que les arguments des « anti-Brexit ». La raison est simple : les informations remontées jusqu’à elle ne sont pas les mêmes que chez son voisin.

Eli Pariser est à l’origine du concept de “bulle de filtre” qu’il a théorisé dans son ouvrage “The Filter Bubble: What The Internet Is Hiding From You” en 2012.

Appelé « bulle de filtres », ce phénomène est amplifié par les algorithmes des différentes plateformes d’Internet qui d’une part, personnalisent le contenu en fonction des attentes de l’internaute et d’autre part, alimentent la polarisation du débat en ligne. Tout est fait pour que le contenu sélectionné pour l’internaute lui plaise et le conforte dans ses propres idées. Voilà pourquoi la désinformation est difficile à endiguer et peut avoir des conséquences dans le monde physique. Lors des élections américaines de 2016, des fermes à trolls russes ont par exemple réussi à déclencher une manifestation islamophobe au Texas, simplement en ciblant des communautés virtuelles avec des messages clivants et sensationnels.

D’après les révélations de Mark Zuckerberg devant le Congrès américain en septembre 2017, les usines à trolls proches du Kremlin comme l’Internet Research Agency auraient investi 100 000 dollars dans le sponsoring publicitaire pour la promotion de discours radicaux. Grâce aux outils de géographie électorale, ils auraient pu également cibler des électeurs plus enclins à voter Donald Trump. En 2017, des journalistes de Propublica harcelés par des trolls ont enquêté sur le coût des méthodes utilisées. Ils ont découvert entre autres qu’il suffit de 45 dollars pour un obtenir 10 000 retweets notamment auprès du site followersandlikes.com.

La fabrique de la désinformation en ligne disposerait donc d’une vraie boîte à outil technologique pour arriver à ses fins. Et ces méthodes ne sont pas forcément illégales ou obscures, ce sont souvent des outils utilisés dans le monde marketing. C’est ce que certains chercheurs à l’école d’administration publique d’Harvard (Harvard Kennedy School) ont expliqué dans un rapport de 2018. Avec un brin de sarcasme, ces derniers ont proposé un un “toolkit” pour mener une campagne de propagande en ligne ultra sophistiquée et précise :

Le rapport Digital Deceit : The Technologies Behind Precision Propaganda on the Internet du Shorenstein Center on Media, Politics and Public Policy (Harvard Kennedy School) apporte plus de précisions sur le mode opératoire des trolls dans leur utilisation détournée et malveillante de la technologie.

- L’achat de publicités en ligne : Grâce aux profils-types issus de l’extraction des données comportementales, le targeting publicitaire aide la désinformation à atteindre une audience réactive et à booster la viralité de ses propres messages.

- Le référencement SEO : Ces techniques dites de “black hat SEO” permettent de jouer avec les algorithmes de référencement et dominer les résultats de recherche d’actualité pendant des heures avant même que Google soit en mesure de corriger la distorsion causée.

- Les services de gestion des médias sociaux (SMMS) À l’intersection entre les algorithmes de machine learning et la technologie de publicité, le SMMS offre un moyen de pré-configurer des messages pour différents types d’audiences sur toutes les plateformes médiatiques simultanément et automatiquement.

- L’Intelligence Artificielle : Les chercheurs envisagent de nouvelles formes plus sophistiquées d’IA dans un futur proche qui vont faciliter encore plus le suivi des données comportementales, la segmentation de l’audience, le ciblage et la gestion de campagnes.

Comment faire pour réguler des flux d’information qui floutent la barrière entre le vrai et le faux ? Ces dernières années, nous avons assisté à une prolifération d’offensives législatives destinées à éradiquer ce phénomène. Mais cette voie juridique s’avère très limitée en pratique et les grandes plateformes peinent à analyser et contenir les millions de messages diffusés sur leurs réseaux. Ensuite, le fact-checking est une voie souvent empruntée pour rétablir la vérité. Les entreprises doivent réagir très vite aux informations qui circulent à leur sujet mais comme nous l’avons vu, ce processus est très long et son efficacité reste inopérante face au scepticisme des foules.

Lorsque les lois se heurtent à la complexité impalpable du web et le fact-checking à la défiance généralisée du public, la solution qui résiste à ces travers est bien de l’ordre du pédagogique. Les organisations doivent miser davantage sur la vulgarisation et la transparence pour convaincre et susciter l’adhésion du public. Former à l’esprit critique est une tâche ardue mais qui, sur le long terme, peut espérer des évolutions majeures.

Tech In Sport

Tech In Sport Green Tech Leaders

Green Tech Leaders International

International Nominations

Nominations Politique publique

Politique publique