Les chercheurs et analystes de tous horizons posent la question de l’impact environnemental du modèle de langage GPT-3 développé par OpenAI. Ils se concentrent sur sa phase d’apprentissage et émettent de nombreuses hypothèses.

Avec près de 200 millions d’utilisateurs en mars dernier selon des chiffres fournis par Similarweb pour les Échos, ChatGPT bat tous les records d’audience. L’agent conversationnel lancé par OpenAI en novembre 2022 séduit de plus en plus d’entreprises à travers le monde. Il vient d’ailleurs d’annoncer le lancement de 70 plugins tiers avec des sociétés aussi prestigieuses qu’Expedia, Kayak, Shopify, Slack et Zapier.

Avec près de 200 millions d’utilisateurs en mars dernier selon des chiffres fournis par Similarweb pour les Échos, ChatGPT bat tous les records d’audience. L’agent conversationnel lancé par OpenAI en novembre 2022 séduit de plus en plus d’entreprises à travers le monde. Il vient d’ailleurs d’annoncer le lancement de 70 plugins tiers avec des sociétés aussi prestigieuses qu’Expedia, Kayak, Shopify, Slack et Zapier.

Mais derrière le succès fulgurant de ce chatbot hors normes se pose la question de son empreinte environnementale. La plateforme Greenly, spécialisée dans la mesure des émissions de CO2, s’est intéressée à la version 3 de ChatGPT, qui repose sur le modèle de langage GPT-3 développé par OpenAI.

A lire aussi : Menace ou opportunité ? L’Académie des Technologies synthétise les forces et faiblesses de l’IA générative

Greenly a pris pour exemple le cas d’une entreprise ayant recours à ChatGPT pour répondre automatiquement à un million de mails par mois pendant un an. Selon cette hypothèse, GPT-3 aurait émis 240 tonnes de CO2e, soit l’équivalent de 136 voyages aller-retour entre Paris et New-York.

Hébergés dans des datacenters, les systèmes d’apprentissage représentent à eux seuls 99 % des émissions totales, soit 238 tCO2e à l’année. Dans le détail, le fonctionnement électrique correspond aux trois quarts de l’empreinte carbone (soit 160 tCO2e), suivi de la fabrication des serveurs (68,9 tCO2e) et de la fuite des gaz réfrigérants (9,6 tCO2e).

Toujours selon Greenly, GPT-3 nécessite entre 100 et 30 000 heures de GPU (Graphics Processing Unit ou unité de traitement graphique) de plus que d’autres solutions IA pour une tâche similaire. Résultat : une consommation électrique plus importante sur plus de serveurs, qui ont besoin d’être refroidis plus longtemps.

ChatGPT : le jeu en vaut-il la chandelle sur le plan environnemental ?

L’étude de l’usage comprend quant à elle le stockage des données permettant d’entraîner GPT-3 à la mission donnée, le transfert des données et l’opération de recherche pour sa bonne exécution. Pour une entreprise répondant automatiquement à 1 million de mails, cette tâche aurait émis 1 277 kgCO2e par an. Par mois, l’empreinte carbone du stockage est évaluée à 85 kgCO2e, le transfert à 11,8 kgCO2e et l’opération de traitement du million de mails, dont la durée est estimée à 38 heures, 9,3 kgCO2e.

« Dans un tel contexte, seul un usage sur le long terme aurait permis de réduire sensiblement l’empreinte carbone de GPT-3 pour l’exécution d’une tâche similaire. Cependant, des doutes subsistent compte tenu de la mise à jour régulière de ces bases de données », analyse Greenly dans un communiqué.

Et Tommy Catherine, expert climat chez Greenly, de compléter : « Malgré les performances fascinantes de ChatGPT, il est légitime de se demander si le jeu en vaut la chandelle sur le plan environnemental. À chaque avancée technologique, les émissions carbone augmentent significativement. Nous savons que des entreprises chinoises comme Huawei et Inspire travaillent déjà sur de nouveaux modèles d’IA ayant plus de 200 milliards de paramètres, de quoi aggraver le réchauffement climatique, au-delà de faire pression sur la consommation électrique mondiale ».

L’équivalent de 205 vols aller-retour entre Paris et New-York pour entraîner GPT-3

Dans une étude, l’université de Californie à Berkeley a de son côté estimé que, dans sa phase d’entraînement, GPT-3 avait consommé 1 287 MWh, ces derniers ayant émis 552 tonnes de CO2e, soit plus de 205 vols aller-retour entre Paris et New-York.

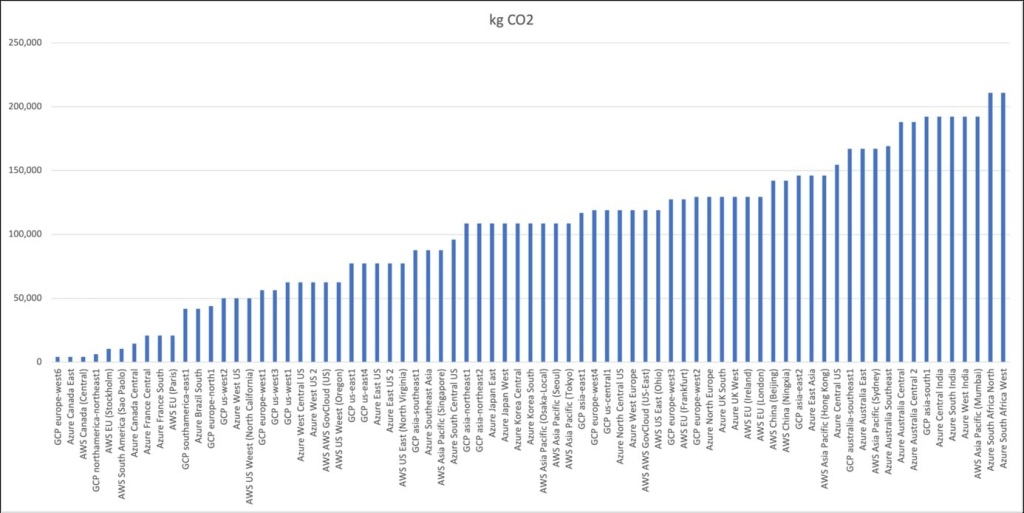

Mais un article du site « Shrink that footprint » rappelle que l’empreinte carbone de GPT-3 dépend de la zone géographique où sont implantés les datacenters sur lesquels l’entraînement est réalisé. L’article met ainsi en évidence des écarts pouvant varier selon un facteur 50.

L’empreinte carbone liée à l’entraînement de GPT-3 selon la localisation géographique des datacenters pour trois fournisseurs : Google (GCP), Amazon (AWS) et Microsoft (Azure). © Shrink that footprint

À l’extrême gauche du graphique se trouvent les serveurs les plus sobres en carbone, qui dépensent environ 4 000 kg de CO2 pour entraîner l’ensemble du modèle. Deux des trois serveurs les plus à gauche se trouvent au Canada, dans des régions où l’énergie hydroélectrique est dominante.

À l’extrême droite du graphique, se trouvent deux sites sud-africains et un site indien, qui dépensent plus de 200 000 kg de CO2 pour l’entraînement de GPT-3. Ces deux pays sont connus pour s’appuyer sur des réseaux électriques à forte intensité de carbone, avec une forte proportion de charbon et de pétrole.

Bien entendu, si l’on compare les chiffres de GPT-3 à ceux par exemple du réseau Bitcoin, les écarts sont gigantesques. Selon une étude de l’Université de Cambridge parue en 2022, près de 200 MtCO2e peuvent être attribuées aux fermes de minage du Bitcoin depuis la création de la cryptomonnaie.

Les émissions annuelles du réseau Bitcoin sont estimées par l’Université de Cambridge à 48,35 MtCO2e. Elles représentent environ 0,10 % des émissions globales de gaz à effet de serre, ce qui correspond aux émissions d’un pays tel le Népal ou la République centrafricaine. De quoi relativiser l’empreinte carbone de GPT-3 et, plus globalement, des grands modèles de langage, même s’il faut rester vigilant par rapport à la progression qu’ils pourraient connaître dans les années à venir.

Tech In Sport

Tech In Sport Green Tech Leaders

Green Tech Leaders Alliancy Elevate

Alliancy Elevate International

International Nominations

Nominations Politique publique

Politique publique