Cet article a été publié originellement sur mydatacompany.fr

La Data science et les algorithmes d’intelligence artificielle sortent des cercles d’initiés. Cette appropriation croissante par les entreprises s’accompagne d’un double impératif d’interprétabilité et d’explicabilité afin de prévenir les accidents industriels. Les principes et les bonnes pratiques de cette éthique s’appliquent dès la conception, c’est « l’Ethical by design ».

Les biais discriminatoires sont l’un d’eux. Amazon a ainsi cessé en 2018 l’utilisation d’un algorithme intervenant dans la présélection de CV de candidats. Apparaissant sexiste, il a été remercié manu militari. La faute en revenait cependant à la base de données, elle-même biaisée, exploitée pour entraîner l’algorithme.

Prévenir les accidents industriels

Les « naufrages » découlant du recours à l’intelligence artificielle sont une menace réelle. La probabilité d’un incident s’accroît du fait de son « appropriation par le plus grand nombre. » De tels accidents risquent in fine de saper la confiance dans cette technologie et de faire perdre aux entreprises les bénéfices de l’intelligence artificielle.

Pour y parer, plusieurs acteurs préconisent une conception des algorithmes basée sur l’éthique ou « ethical by design », en référence aux concepts déjà mis en avant en particulier par la Cnil (Commission nationale de l’informatique et des libertés) de « Privacy by design » et de « Security by design », c’est à dire de l’intimité et de la sécurité dès la conception.

Savoir expliquer les algorithmes pour éviter le phénomène de boîte noire

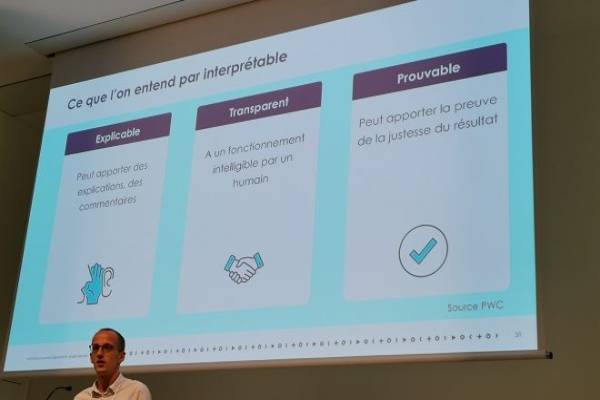

L’approche repose en particulier sur l’interprétabilité du fonctionnement et l’explicabilité des décisions afin d’éviter le phénomène de boîte noire, c’est à dire d’un algorithme qui sort un résultat qu’il faut accepter tel quel.

C’est là que la situation se corse. La complexité vient bien souvent mettre des bâtons dans les roues de l’interprétabilité. Or les sources de complexité sont multiples, à commencer par les modèles mathématiques eux-mêmes. Emmanuel-Lin Toulemonde, également Data scientist chez Octo Technology, parle même « d’empilement de complexités. »

N’est-ce pas une raison suffisante de leur préférer des modèles plus simples et donc plus faciles à interpréter ? C’est une possibilité, mais pas nécessairement la plus satisfaisante en termes de performances. « Il faut trouver un équilibre » répond-il.

Si la complexité dessert l’explicabilité, elle « sert souvent la performance » souligne-t-il. « Afin de maximiser l’utilité de votre système de data science, il va falloir trouver un juste équilibre entre performance et interprétabilité » préconise-t-il.

Des méthodes pour rendre interprétables les systèmes de Data science

Cet équilibre ne servira pas seulement en interne à comprendre le fonctionnement d’un algorithme. Les utilisateurs eux-mêmes sont en droit d’attendre des réponses. Les résultats doivent pouvoir leur être expliqués. L’interprétabilité intéresse également, et de plus en plus, les régulateurs. C’est déjà le cas de la BCE (Banque Centrale Européenne) dans le secteur de la finance.

Pour qui ? Pourquoi ? Que cherchez-vous à comprendre ?

Les différentes populations interagissant avec les systèmes de Data science n’ont pas les mêmes attentes. La démarche d’interprétabilité devrait alors reposer sur quatre questions : Pour qui ? Pourquoi ? Que cherchez-vous à comprendre ? Quel effort êtes-vous prêt à y consacrer ?

En répondant à ces 4 questions et selon les réponses apportées, « les méthodes pour rendre vos systèmes interprétables seront très différentes » prévient le consultant. Des pistes existent déjà, et toutes ne sont pas de nature technique.

Un exemple ? Le bon sens métier. Une discussion avec les métiers lors de la conception permettra d’identifier des indicateurs pertinents. Dans le domaine de la maintenance prédictive, ces indicateurs seront par exemple les facteurs de panne.

Le métier sait de quoi il parle

« Vous allez implémenter cet indicateur dans votre système de Data science. Ce sera un indicateur facilement compréhensible. De plus, il aura certainement tendance à booster la performance de votre système parce que votre métier sait de quoi il parle » précise Emmanuel-Lin Toulemonde.

L’humain et la pédagogie contribueront également à une meilleure compréhension. Le recours à des outils visuels le favorisera aussi, via la « data visualisation » des données prises en compte dans le système pour parvenir au résultat.

Un empilement de complexités dès la collecte de l’information

Les entreprises ont les moyens aujourd’hui d’interpréter et d’expliquer des algorithmes. Cela ne va cependant pas sans difficultés du fait d’un « empilement de complexités, qui commence dès l’information de base que vous collectez. »

Cette démarche réclame donc une volonté et des efforts, que la réglementation ou des enjeux business pourraient in fine imposer. Elle ne repose pas sur les seuls experts que sont les Data scientists, mais sur « toutes les personnes gravitant autour de votre système de data science », chacune ayant ses propres attentes. Les techniques devront par conséquent être adaptées aux objectifs visés.

S’inspirer des bonnes pratiques du développement logiciel

L’éthique dès la conception peut s’inspirer des bonnes pratiques du développement logiciel. On en identifie quatre principales :

Des bonnes pratiques de développement. Le monde du logiciel est une source d’inspiration susceptible de s’appliquer au monde de la Data science, productrice de code. Le bénéfice ? « Donner une caractéristique de reproductibilité aux systèmes, c’est à dire la capacité à refaire la même chose, à rejouer la même situation et de parvenir à un résultat similaire. »

Garantir la traçabilité des données depuis la collecte de l’information dans les différents systèmes d’information jusque dans le système de Data science, sans oublier de tracer les manipulations apportées au cours du processus.

Commencer simple grâce à un modèle de Data science simple, par exemple un arbre de décision, et mesurer la performance. « Cela permettra de mesurer l’apport de performance d’un ajout de complexité et ainsi d’évaluer le bénéfice d’un sacrifice de l’interprétabilité. »

Recourir à des algorithmes spécifiques : des algorithmes répondent aux besoins d’explicabilité et d’interprétabilité. Tree Interpreter en est un exemple. « Ces algorithmes sont utiles si vous cherchez des explications, mais pas forcément si l’objectif est la transparence. »

Tech In Sport

Tech In Sport Green Tech Leaders

Green Tech Leaders International

International Nominations

Nominations Politique publique

Politique publique